¿Qué es un fichero robots.txt y por qué es importante para tu SEO? En pocas palabras, robots.txt es un set de guías que le dicen al buscador a qué partes de tu web pueden acceder. De hecho, muchos buscadores ya tienen robots.txt para saber esto de antemano. Robots.txt también ayuda en el proceso de indexación que, posteriormente, permitirá que tu web aparezca en la página de resultados.

Si estás teniendo problemas con la indexación de tu web, probablemente tu fichero robots.txt es el culpable. Normalmente, son de los errores SEO más frecuentes que ocurren y puede provocar y desplome significativo de tu posición en el ranking.

En esta guía te enseñaremos en profundidad qué es un fichero robots.txt y cómo usarlo en WordPress y otros sistemas.

¿Qué es robots.txt?

Robots txt es un fichero localizado en la raíz o la parte más básica de tu web. Sirve de guía de instrucciones para los rastreadores SEO, ya que les dice qué partes tienen que rastrear y cuáles no.

¿Qué es un rastreador de webs y cómo funciona?

Un rastreador de webs es un bot de internet, generalmente dirigido por Google o Bing. Básicamente, su trabajo es analizar la información que hay en una we y catagolizarla para que a la hora de la búsqueda los usuarios interesados la puedan encontrar.

No todos los rastreadores tienen la misma función, hay algunos por ejemplo que les sirven a los motores de búsqueda, mientras que otros tienen un fin comercial. El funcionamiento es más o menos el mismo, donde está la mayor diferencia es en el propósito que se le quiera dar al rastreador.

¿Por qué es importante tener a los rastreadores de webs en cuenta?

Los rastreadores siguen las instrucciones que el fichero robots.txt les ordene. El problema es que hay bots que pueden manchar el SEO de tu web, ya que son spam o malware.

Tienes que hacer un esfuerzo por entender un poco el funcionamiento de los rastreadores y ver el comportamiento que tienen en tu web. Hay casos en los que un indeseado rastreador SEO puede aparecer y destrozar la experiencia del usuario.

Personalizar robots.txt

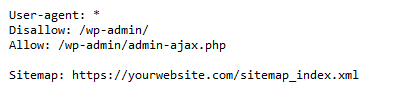

Así es como ve un rastreador el fichero robots.txt por defecto:

Partes de un fichero robots.txt

User-agent

El agente de usuario se refiere al nombre del rastreador de SEO para el que estaba destinado el comando. Es la primera línea de cualquier formato de robots.txt.

Cada bot tienen su propio nombre, por ejemplo, Google los llama «Googlebot«, Bing lo llama «BingBot» y Yahoo los llama «Slurp».

Allow, Permisos

El comando de permisos del robots.txt indica a qué contenido puede acceder cada agente de usuario. Tienes que tener en cuenta que el protocolo tiene que señalar un camino para estos agentes de usuario, porque si no esta parte no servirá de nada.

Disallow, Prohibición

El comando de prohibición del robots.txt es el que ordena cuáles son las URLs a la que no hay que acceder. Sucede lo mismo que con los permisos, tiene que estar claro para el bot, porque de lo contrario se lo saltará.

Mapa de sitio

El comando de mapa de sitio se usa para señalarle a los rastreadores donde encontrar el sitemap XML del sitio.

Crawl-delay

El comando de crawl-delay es compatible con los rastreadores principales. Básicamente lo que hace es permitir a los administradores que ordenen a Google cuánto tiempo quieres que esté rastreando la página.

Host

El comando hots le dice a los rastreadores tu dominio espejo preferido o la réplica de tu web en un servidor diferente. El dominio espejo se usa para distribuir el tráfico de manera que la latencia y el servidor no se atasquen.

Comentarios

Los comentarios sirven de guía para el diseño y el desarrollo de la web y son precedidos por un ‘#’. Esto se hace para que comandos que uses con WordPress no afecten a los rastreadores, ya que al ver el hastag lo ignorarán.

# Ejemplo fichero robots.txt

User-agent: * # Se aplica a todas los buscadores.

Disallow: /wp-admin/ # Bloqueo acceso al directorio /wp-admin/

Disallow: /calendario/ # Bloqueo acceso al directorio /calendario/

Disallow: /eventos/ # Bloqueo acceso al directorio /evantos/

User-agent: BingBot

Disallow: /calendar/

Disallow: /events/

Crawl-delay: 10

Sitemap: https://yourwebsite.com/sitemap.xml

Host: yourwebsite.com

¿Para qué se usa robots.txt?

La sintaxis de robots.txt se usa para dirigir el tráfico de tu web. Es un rol fundamental el generar tráfico a tu web y hacerlo a la vez más accesible a los motores de búsqueda.

¿Quieres aprender a usar este fichero y crear robots.txt para tu web?

Aquí tienes 7 consejos que te ayudarán con robots.txt y tu mejora SEO:

- Evita sobrecargar tu sitio web con solicitudes de rastreo web y bot de búsqueda de Google.

- Evita que los rastreadores entren en páginas que no quieres con el comando de prohibición, nowfollow.

- Protege tu web de bots malos.

- Evita duplicar contenido que salga en una misma búsqueda.

- Oculta las páginas que no hayas terminado a los rastreadores hasta que estén preparadas para su publicación.

- Mejora la experiencia de usuario.

- Ten una construcción de enlaces internos fuerte.

Con estos consejos verás cómo mejorará tu SEO y empezarás poco a poco a manejar los robots.txt.

¿Todos los sitios web necesitan crear texto de robot?

No todos los sitios web necesitan crear un archivo robots.txt. Los motores de búsqueda como Google tienen sistemas establecidos sobre cómo rastrear las páginas del sitio web, y automáticamente ignoran las versiones duplicadas o sin importancia de una web.

Los especialistas técnicos en SEO, sin embargo, recomiendan que cree un archivo robots.txt e implemente las mejores prácticas de robots.txt para permitir un rastreo web e indexación más rápidos y mejores por parte de los robots de rastreo de Google y otras arañas de búsqueda.